Glottodydaktyczne aspekty kognitywnego ujęcia metafory1

W przeciwieństwie do generatywizmu autonomicznego, językoznawstwo kognitywne jest konstruktem interdyscyplinarnym i takie podejście do glottodydaktyki jest podstawą wszelkich dociekań naukowych. Badanie akwizycji języka obcego nie może odbywać się w sposób autonomiczny, wykluczający takie nauki jak psycholingwistyka, semantyka, semiotyka czy pragmatyka.

Uczenie się (czy raczej proces uczenia się) trzeba rozpatrywać dzisiaj z perspektywy ustaleń teorii pamięci, tj. ze zwróceniem uwagi na zagadnienia spostrzegania, wyobrażania, rozumienia, zapamiętywania, przypominania. O efektywności uruchamiania tych procesów […] decyduje przede wszystkim natura treści lub znaczenia i rozumienia. Procesy te należy rozpatrywać z punktu widzenia określonych ustaleń psycholingwistyki, semantyki kognitywnej i semiotyki, a więc interdyscyplinarnie[…] (Gorczyca 2000: 77).

Teoria kognitywna bierze pod uwagę interpretacyjną aktywność umysłu, przejawiającą się w aktach użycia języka w taki sposób, by uchwycić owo charakterystyczne (re)konstytuowanie się językowych fenomenów znaczących w rezultacie podporządkowywane zasobom symbolicznym języka <woli sensu> użytkowników dążących do zrealizowania zasadniczego celu interakcji – <wyprodukowania> i <uaktywnienia>: ostatecznie przekazania i uświadomienia sobie znaczenia (Korżyk 1994: 144). Lingwistyka kognitywna, opierając swoją teorię na uzusie językowym, tym samym poszerza swoje spektrum badań o obszar semantyczny, semiotyczny czy pragmatyczny.

Realistyczność (nie: realizm w sensie technicznego terminu epistemologii) i redukcyjność osiąga gramatyka kognitywna dzięki temu, że jest nie tylko teorią języka, ale także empirycznym programem jego badania, wolnym od restrykcji, jakie zwykle wiążą się z przyjęciem w badaniach lingwistycznych jakiejś aksjomatyki. Jej celem jest przedstawienie całego spektrum możliwości <językowego opracowania> i komunikowania sensu, jakimi dysponuje mówiący oraz językowych środków, które to umożliwiają. Omawiana teoria bierze równocześnie pod uwagę także struktury konceptualne umysłu oraz procesy kognitywne, w takim zakresie, w jakim konstytuują one potencjał językowy mówiącego (Korżyk 1994: 145).

Oparta na takiej koncepcji teoria glottodydaktyczna musi być interdyscyplinarna, czerpie bowiem wiedzę z teorii pokrewnych.

Jeżeli zatem glottodydaktyka ma dotyczyć praw uczenia się i adaptować je do określonego procesu (np. lekcyjnego), to musi być rozpatrywana z punktu widzenia psycholingwistyki (np. w kwestii teorii pamięci), neurolingwistyki (np. w kwestii przetwarzania informacji) oraz semantyki kognitywnej w kwestii <miejsca> znaczenia jako zmiany prototypu pojęcia znaczenia języka obcego – zmiany znaczenia prototypu w języku A w stosunku do języka B, który jest przedmiotem nauczania – (Gorczyca 2000: 77).

To właśnie lingwistyka kognitywna, w przeciwieństwie do behawioryzmu, czy późniejszego generatywizmu, stawia znaczenie na czele swoich zainteresowań. Glottodydaktyczna teoria języka musi więc interesować się znaczeniem i rozumieniem, które nie sposób rozpatrywać w sposób autonomiczny. Zatem u podstaw konstruowania zrębów nowej teorii glottodydaktycznej leżeć powinno zagadnienie znaczenia, a ściślej semantyczny układ słownictwa w aparacie językowym – słownictwa, które jest centralnym elementem języka oraz problem recepcji w tekście słuchanym i czytanym. Kwestię motywacji interdyscyplinarnych badań nad akwizycją języka obcego trafnie podsumowuje K. Korżyk:

Propozycja prowadzenia przez językoznawców badań o charakterze interdyscyplinarnym jest prostą konsekwencją faktu, że lingwistyka jest nauką nie-nomotetyczną. Jednym z wniosków, jaki stąd wypływa, jest konieczność rygorystycznego kontrolowania wartości dokonywanych w jego obrębie ustaleń, poprzez konfrontowanie ich z danymi uzyskanymi w innych dziedzinach poznania. W takiej sytuacji najbardziej obiecującym […] rozwiązaniem wydaje się być to włączające lingwistykę w strukturę programu badawczego nauk kognitywnych (Korżyk 1994: 147).

Dodajmy, że motywacja przeprowadzenia badań interdyscyplinarnych wynika bezpośrednio z ogólnych tendencji w badaniach humanistycznych:

Jeśli jednak, pomimo szalejącego pluralizmu, można by dzisiaj (bardzo ostrożnie) powiedzieć o jakiejś najbardziej wpływowej idei teorii, to należałoby ją określić jako: szerokie, interdyscyplinarne, wielokontekstowe i zmienne historycznie uniwersum wszelkiej wiedzy użytecznej w procesie czytania literatury – a więc jako dziedzinę, która nie tworzy fundamentów, kryteriów czy uzasadnień dla praktyk interpretowania literatury, ale wzbogaca ją maksymalnie, dostarczając im coraz to nowych języków i kontekstów (Burzyńska , 2007a: 38).

To interdyscyplinarne podejście w naukach humanistycznych musi odzwierciedlać się również w badaniach nad językiem, co właśnie proponuje językoznawstwo kognitywne. Przedstawmy zatem krótką charakterystykę kognitywnej teorii języka.

W gramatyce kognitywnej język jest uważany za uporządkowany inwentarz konwencjonalnych jednostek lingwistycznych (structured inventory of conventional linguistic units). Jednostki (zautomatyzowane sekwencje operacji kognitywnych) składające się na wiedzę językową użytkownika ograniczają się do struktur semantycznych, fonologicznych i symbolicznych, które albo pojawiają się w roli składników rzeczywistych wypowiedzi językowych, albo też wyłaniają się z tych ostatnich poprzez procesy abstrahowania (schematyzacji) oraz kategoryzacji (Langacker 2003: 41).

Jednostki lingwistyczne mogą być proste lub złożone, od morfemu po fragment tekstu i powstają w procesie habituacji, tj. stopniowego utrwalania się danej struktury językowej. „Kiedy dana jednostka językowa-semantyczna, fonologiczna lub schemat […] zostaje utrwalona do takiego stopnia, że jej aktywowanie nie wymaga wysiłku umysłowego, staje się ona pewną uformowaną całością, jednym z elementów listy“ (Fife, 1994a: 14). Nowe formy językowe powstają w oparciu o abstrakcyjne wzorce struktury języka, zwane schematami. Wiedzę gramatyczną nabywamy w procesie wyabstrahowywania z rzeczywistych użyć językowych bardziej schematycznych reprezentacji (schematów konstrukcyjnych) (Dąbrowska Kubański, 2003: 19). Wiedzę użytkownika języka można zatem przedstawić w postaci złożonych w pary zestawień forma-znaczenie, określanych jako jednostki symboliczne.

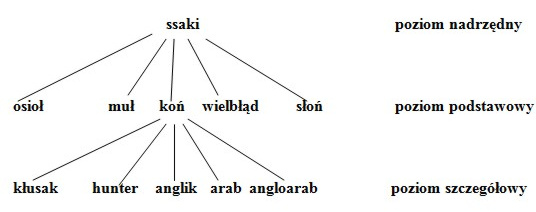

Nieodzownym procesem jest tutaj proces kategoryzacji, która pozwala lepiej zrozumieć siebie i innych ludzi oraz otaczającą nas rzeczywistość (Gorczyca, 2007: 23). Zdaniem kognitywistów, kategorie nie są wrodzone, ale uczymy się ich. Jak pisze Langacker kategorie językowe są zazwyczaj złożone i powstają w wyniku procesu abstrahowania schematów, rozszerzania ich oraz wyłaniania się jednostek bardziej szczegółowych z jednostek o większej ziarnistości – w miarę wprowadzania bardziej subtelnych rozróżnień i uzyskiwania przez konkretne realizacje statusu jednostkowego (Langacker, 2003: 47‑48). Proces kategoryzacji przebiega według następującego scenariusza: obiekt docelowy kategoryzacji aktywuje szereg utrwalonych jednostek, które mogą posłużyć do jego kategoryzacji. Jednakże tylko jedna jednostka ze zbioru aktywacji może posłużyć kategoryzacji obiektu docelowego. Jej wybór jest usankcjonowany kilkoma interakcyjnymi czynnikami: poziomem utrwalenia, kontekstem oraz posiadaniem wspólnych cech przez aktywowaną jednostkę i strukturę docelową. Z procesem kategoryzacji silnie związane jest pojęcie prototypu, jako najbardziej charakterystycznego reprezentanta danej kategorii. Prototyp na poziomie reprezentacji mentalnej stanowi amalgamat cech najlepszego reprezentanta danej kategorii. Kognitywiści traktują prototyp jako układ odniesienia dla danej kategorii. Prototyp jest idealnym odwzorowaniem tego, co kategoria ma przedstawiać – niezmiennym jądrem kategorii, nie będąc wartością statyczną (Gorczyca 2007: 23). W każdej kategorii istnieją lepsze lub gorsze egzemplarze, a uznanie danego egzemplarza za prototypowy jest usankcjonowane językowo i kulturowo. Prototyp pojawia się na skrzyżowaniu dwóch płaszczyzn jako wypadkowa napięcia istniejącego pomiędzy tendencją do maksymalnej inkluzji i tendencją do maksymalnej segmentacji. Z glottodydaktycznego punktu widzenia wiedza na temat kategoryzacji pojęć ma niebagatelne znaczenie dla wielu aspektów procesu nauczania języka obcego. Przede wszystkim dotyczy to tzw. ćwiczeń kategoryzacyjnych, prowadzonych w ramach ćwiczeń leksykalnych oraz ćwiczeń związanych z czytaniem tekstu. Na poziomie recepcji będzie to kwestia wyboru z tekstów obcojęzycznych określonych pojęć będących prototypami i naniesienie ich na procesy kognitywne uczącego się. Będziemy tu mieli do czynienia z rozpoznawaniem pojęć i dopasowywaniem ich do kontekstu na bazie uruchamiania kodu językowego i obrazowego. Kolejnym etapem będzie rekategoryzacja tych pojęć na bazie pamięci operacyjnej. Rekategoryzacja pojęć w ramach ćwiczeń leksykalnych będzie polegać na takich procesach jak uchwycenie relacji i zależności między kategoriami oraz wnioskowanie. Ważnym aspektem jest tutaj zwrócenie uwagi na różnice między językami: ojczystym (L1) i docelowym (L2) podczas prezentacji, wdrażania oraz kontekstualizacji materiału językowego oraz na sposób metaforyzacji pojęć w obrębie danego języka (Gorczyca, 2007: 27‑28). Teoria kategoryzacji może również mieć zastosowanie w przypadku odczytywania metafory, szczególnie metafory-porównania (np. Waleczny jak lew). Systemy kategorialne występują jednocześnie na dwóch płaszczyznach – na płaszczyźnie pionowej podporządkowane są na różnych poziomach zawierania, natomiast na płaszczyźnie poziomej ulegają segmentacji w obrębie jednego i tego samego poziomu.

Im bardziej obszerna kategoria, tym wyższy poziom abstrakcji w płaszczyźnie pionowej. W płaszczyźnie poziomej natomiast występuje gradacja ciężaru gatunkowego, przypisywanego poszczególnym reprezentantom danej kategorii (Gorczyca, 2007: 23‑24). Z punktu widzenia glottodydaktyki najważniejszy jest poziom podstawowy (bazowy), który uruchamia kod wyobrażeniowy.

Podsumowując uwagi o procesie kategoryzacji, możemy wysunąć następujące wnioski:

- Kategoryzacja odbywa się poprzez schemat lub poprzez prototyp, choć zdaniem Langackera są to w zasadzie dwa aspekty tego samego zjawiska.

- Kategorie mają układ hierarchiczny (poziom podstawowy, poziomy: nadrzędny i szczegółowy)

- Kategorie są wynikiem uczenia się, a nie czymś wrodzonym.

- Przynależność do danej kategorii następuje na podstawie podobieństwa do prototypu. To ustalenie można odnieść do interesującego nas tematu w perspektywie myślenia asocjacyjnego oraz abstrahowania. Związane jest to z kwestią przynależności do określonych prototypów atrybutów w języku ojczystym (A) oraz z wyznaczaniem ich przynależności i progu oraz funkcjonowania w języku obcym (B).

Odnieśmy się do dwóch przykładów kategoryzacji na poziomie podstawowym (osioł i słoń). W języku ojczystym mamy dwa związki frazeologiczne o charakterze metafor-porównań związanych z tymi reprezentantami ssaków. O człowieku mówimy, np.: uparty jak osioł. O kimś, kto jest niezdarny, np.: jak słoń w składzie porcelany. Dla uczącego się, w języku ojczystym te dwa gatunki ssaków będą stanowiły charakter prototypowy. Jednakże przy uczeniu się sensów tych związków frazeologicznych w języku docelowym, nastąpi rekategoryzacja związana z dopasowywaniem nazw innych zwierząt. W języku angielskim na przykład, odpowiednikiem osła będzie muł (as stubborn as a mule), a słonia – byk (like a bull in a china shop). Będziemy tutaj mieli do czynienia z profilowaniem kulturowym oraz z rozszerzeniem metaforycznym, w tym sensie, że w sformułowanie like a bull in a china shop oznacza jednocześnie człowieka nietaktownego, co nie występuje w języku polskim. Uczący się nie tylko musi przerekategoryzować nazwy ssaków, lecz również nadać nieco inny profil znaczeniu związku frazeologicznego.

W procesie nauczania języka obcego mamy właśnie do czynienia z rekategoryzacją pojęć, a także z ich przerekategoryzowywaniem. W wyniku ćwiczeń rekategoryzacyjnych uczący się lepiej zapamiętuje leksykę, lepiej nią operuje. Przyczynia się to niewątpliwie do lepszego ukształtowania czytania selektywnego, a co za tym idzie, lepszego mówienia.

W analizie kognitywnej najważniejsze jest pojęcie profilu, czyli zespołu modeli konceptualnych i relacji, na podstawie których wyodrębnia się daną jednostkę języka (symboliczną, fonologiczną lub semantyczną) w danej wypowiedzi. Profilowanie lub nałożenie profilu na bazę są elementami obrazowania, jednego z podstawowych procesów kognitywnych. „Określenie bazy i profilu danego predykatu jest jednym z najważniejszych elementów analizy semantycznej. W istocie – przez wprowadzenie pojęcia profil – jesteśmy w stanie opisać podstawowe kategorie gramatyczne – rzeczownik, czasownik i przymiotnik“ (Fife, 1994b: 29). Przenosząc te zjawiska na grunt glottodydaktyczny, będziemy mieli do czynienia z profilowaniem kulturowym i profilowaniem tekstowym. W sytuacji profilowania kulturowego (a z tym mamy do czynienia szczególnie w nauczaniu języka obcego) rezultatem profilowania są skonwencjalizowane i mające charakter metaforyczny, właściwe danemu językowi, całościowe modele pojęciowe. Zawierają one twarde inwariantne jądro znaczeniowe oraz słabsze utrwalone cechy konotacyjne. „Profilowanie tekstowe w sensie glottodydaktycznym powinno wysunąć pewne fragmenty ramy na plan pierwszy, nie gubiąc jednak odniesień do całości ramy“. Ważną tutaj kwestią jest wyznaczanie przynależności, granicy i progu oraz określanie różnic (tzw. konstrukty ograniczające) jak również niwelowanie różnic, definiowanie (konstrukty łączące) oraz uogólnianie różnic, transfer reguł, dostrzeganie analogii (konstrukty propozycjonalne). Konstrukty te pośredniczą w porównaniu dwóch elementów: standardu porównania i celu porównania, a więc w korelacji konceptualnej elementów (Gorczyca, 2000: 95‑96).

W ten sposób badania nad metaforą poetycką w ujęciu glottodydaktycznym powinny wyeksponować profilowanie kulturowe, które będzie polegało na uwypukleniu kontekstu. Będzie tutaj chodziło o porównywanie elementów oraz o ich konceptualne skorelowanie. W grę będą wchodziły myślenie analogiczne (dostrzeżenie podobieństwa) oraz myślenie metaforyczne, które opiera się m.in. na abstrahowaniu. W przypadku metafory z życia codziennego (tzw. sztywnej metafory) również mamy do czynienia z profilowaniem kulturowym. Jednak zakres funkcjonowania sensów jest tutaj o wiele mniejszy i bardziej ustabilizowany2.

Językoznawstwo kognitywne przedstawia nam tradycyjne pojęcie reguły (tu schematu) w zupełnie nowym świetle. W przeciwieństwie do założeń gramatyki generatywno-transformacyjnej Noama Chomsky’ego, reguły nie są algorytmicznymi tworami, określającymi sposób łączenia elementów języka w procesie generowania zdań. Reguły gramatyczne są w lingwistyce kognitywnej sprowadzone do konstrukcji gramatycznych, które są „złożonymi jednostkami symbolicznymi o maksymalnym stopniu schematyzacji“ (Langacker, 2003: 75). Zdaniem Langackera tak pojmowane reguły są nieodzowne: Pytanie więc brzmi, czy reguły (schematy) mogą być całkowicie wyeliminowane na rzecz bezpośredniego modelowania nowych wyrażeń na podstawie już znanych? Sądzę, że odpowiedź na to pytanie może być tylko negatywna. Opis oparty wyłącznie na analogii (czyli taki, który nie postuluje żadnych abstrakcji lub schematyzacji) jest całkowicie sprzeczny z opartą na pojęciu uzusu zasadą, że język manifestuje wzorce na wszystkich poziomach ogólności. Byłby on także wewnętrznie niekonsekwentny, ponieważ nawet uczenie się konkretnych wyrażeń (konieczne dla stworzenia podstawy do analogii) wiąże się z abstrahowaniem i schematyzacją od rzeczywistych wypadków użycia językowego.

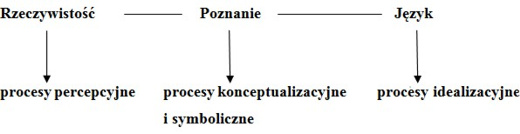

Rozważmy teraz proces akwizycji w oparciu o interakcyjny model Langackera: Rzeczywistość ↔ Poznanie ↔ Język. Model ten zakłada wzajemne oddziaływanie rzeczywistości (nie tylko językowej), poznania (czyli procesów poznawczych) i języka. Przenosząc to na grunt psycholingwistyczny, Rzeczywistość będą stanowiły procesy percepcyjne, Poznanie – procesy konceptualizacyjne i symboliczne, a Język – procesy idealizacyjne. Mamy zatem do czynienia z następującym modelem (Gorczyca, 2007: 30).

W odniesieniu do glottodydaktyki, procesy percepcyjne polegają m.in. na hipotecznym rozstrzyganiu o adekwatności dopasowywania oglądanych, słuchanych i czytanych tekstów, w tym leksyki i zwrotów językowych, do nazw pojęć występujących w danym języku obcym (język B), znajdujących się w tzw. magazynie pamięci deklaratywnej i proceduralnej oraz na konfrontowaniu ich z doświadczeniem ucznia jako użytkownika języka ojczystego (język A). Procesy konceptualizacyjne to na przykład utrwalone pojęcia, doświadczenie kinetyczne, emotywne, rozpoznanie kontekstu społecznego, kulturowego, fizycznego, lingwistycznego itp. Na gruncie glottodydaktycznym interesuje nas relacja pomiędzy obrazem świata (w tym także językowym obrazem świata), zadaniem dydaktycznym, stymulującym procesy poznawcze, w efekcie czego następuje unaocznienie rzeczywistości w języku. Biorąc pod uwagę w/w elementy, Langackerowski model sieciowy przybiera następującą postać: Obraz świata ↔ zadanie dydaktyczne ↔ unaocznienie rzeczywistości w języku.

Tworzenie się obrazu świata jest problemem semiotycznym, uwarunkowanym kulturowo. Za przedmiot badań kultury uważa się <drugą rzeczywistość>, która ma charakter semiotyczny i formułuje tzw. <obraz świata>. Zjawiska semiotyczne, składające się na <drugą rzeczywistość>, a więc między innymi wypowiedzi i teksty językowe, tworzą w różnych kulturach często odmienne obrazy świata.

W procesie programowania zadania dydaktycznego oraz w procesie unaocznienia rzeczywistości w języku najważniejszym aspektem będzie uchwycenie sensu semiotycznego rozumienia. Rozumienie, w naszym pojęciu nie ogranicza się „[…] do rozumienia warunków prawdy i fałszu, lecz także do metafory […]. Rozumienie zdania, sytuacji (kontekstu) nie jest niczym innym jak zdolnością korelowania konceptualizacji (kojarzenia)“ (Nowakowska-Kempna, 1995: 223). Rozumienie konceptualne i rozumienie aktualne jest oparte na kojarzeniu: nie jest ono aktualnym uświadamianiem sobie samemu przedmiotu, który jest znaczony przez to, co jest w dany sposób rozumiane. Bez kojarzenia nie ma rozumienia (Jadacki, 1990: 15). Odnieśmy się tutaj do teorii semiotycznej Ch. S. Peirce’a, opartej na znaku, pojmowanym w sposób triadyczny, jako połączenie materialnego środka przekazu, przedmiotu oraz znaczenia. Znaczenie znaku (tzw. interpretant) jest jednocześnie kolejnym znakiem lub ciągiem znaków, wyrażających treść.

Innymi słowy każda treść znaku […], każdy znak w koncepcji Peirce’a jest więc interpetantem kolejnego znaku, a zarazem jako znak posiada swojego interpretanta w postaci innego znaku […]. Konsekwencje takiego założenia były bardzo istotne. Każdy znak zakładał bowiem zawsze inny znak, a znaczenie było dostępne tylko poprzez interpretację – czyli przekład danego znaku na kolejne znaki (Burzyńska, 2007b: 236).

Rozumienie zatem polega na przekładzie znaku na znak i jest to operacja o wiele bardziej skomplikowana aniżeli ta, która funkcjonuje w glottodydaktycznym wyobrażeniu R. Pawłowskiej:

Spełnieniem zdarzenia językowego jest akt odbioru językowego. Składają się nań następujące operacje: rozpoznawanie znaków językowych pisanych, mówionych czy innych w ich materialnej postaci za pomocą widzenia, słyszenia, czucia przez porównanie z wzorcami zapamiętanymi w ośrodkach mowy; identyfikacje znaczeń, czyli odniesienie znaków językowych do oznaczonej przez nie rzeczywistości też poprzez pamięć skojarzeń znaków ze znaczeniem; uświadomienie funkcji tekstu i intencji nadawcy zakodowanych w tekście; weryfikacja znaczeń w konsytuacji i w kontekście. Wszystkie te operacje umysłowe prowadzą do rozumienia tekstu językowego (Pawłowska, 1992: 17)

I choć autorka dalej zwraca uwagę na kontekst i procesy psycholingwistyczne, to jej koncepcja rozumienia oparta jest na prostym procesie przyporządkowywania znaczenia danemu znakowi. Model sieciowy Langackera ujmuje problem znaczenia w sposób o wiele bardziej skomplikowany.

Z koncepcji Langackera wynika, że znaczenia nie można wyjaśnić bez zbadania ludzkiego aparatu kognitywnego, natomiast zasad działania umysłu nie da się przedstawić i zrozumieć bez analizy struktury języka, który jest głównym i podstawowym sposobem artykułowania myśli. Dzięki temu możemy rozwiązać dylematy procesualnej koncepcji poznania, zakładającej, że nie ma trwałych i niezmiennych podstaw poznania, nie ma tym samym jednej i stałej reprezentacji semantycznej, natomiast znaczenie jednostki językowej zależy od jej pozycji w tekście i uzgodnienia z innymi elementami (Gorczyca, 2007: 31).

Najlepszą egzemplifikacją, według nas, takiego ustalenia jest znaczenie metaforyczne.

Analizą metafor przez wiele lat zajmowali się głównie lingwiści i badacze literatury, ale obecnie metafory stały się również przedmiotem badań interdyscyplinarnych. Zajmują się nimi psychologowie (szczególnie psycholingwiści), specjaliści w dziedzinie kognitywistyki, logicy oraz filozofowie. Interesuje ich głównie problematyka znaczenia i przenoszenia znaczenia w wyrażeniach metaforycznych, a także ogólniejsza problematyka umysłu. Problematyką metafor oraz specyficznością kulturową tej szczególnej aktywności poznawczej ludzi zajmują się również antropologowie, badający różne kultury (Chlewiński, 1999: 268). Językoznawstwo kognitywne, jako interdyscyplinarna teoria języka patrzy na metaforę z perspektywy jej tworzenia, rozumienia i znaczenia w oparciu o kontekst i tło kulturowe. Z perspektywy psycholingwistyki, najważniejszym zagadnieniem będą procesy myślowe odpowiadające zjawisku powstawania i recepcji metafory, takie jak myślenie metaforyczne, abstrahowanie, myślenie per analogiam czy dedukcja hipotetyczna. Metafory i analogie stanowią przedmiot badań wielu specjalistów, ponieważ – jak zauważono – są istotnym narzędziem poznania i prawdopodobnie odgrywają poważną rolę w funkcjonowaniu systemu poznawczego (Chlewiński, 1999: 285‑286). Wspominaliśmy już, że językoznawstwo kognitywne stawia w nowym świetle zagadnienie metafory, traktując ją jako zjawisko wszechobecne, nie tylko w języku, lecz także w naszych myślach i wyobraźni. Kwestię tę rozważa A. Barcelona:

The cognitive theory of metaphor and metonymy is a fundamental aspect of the enterprise of cognitive sciences. […] One of the major general abilities is imagination, or in more technical terms, the ability to project concepts onto other concepts. And that is why such imaginative devices as metaphor and metonymy have become an object of prime interest for cognitive scientists Barcelona (Barcelona, 2003: 2‑3).

Podobne stanowisko zajmuje R. Kalisz:

Metafory pełnią znacznie większą rolę i posiadają inny status w teorii językoznawstwa kognitywnego niż większość innych teorii językoznawczych, logicznych, czy filozoficznych, w których metafory są traktowane jako zjawiska peryferyjne. Takie teorie koncentrują się głownie na tzw. dosłownym znaczeniu wyrażeń. Znaczenie metaforyczne jest traktowane jako drugorzędne, mniej ważne, występujące wtedy, kiedy reguły kolokacyjne słów są pogwałcone (przede wszystkim w generatywizmie – K.R.). Językoznawstwo kognitywne traktuje metaforę jako centralne zagadnienie teorii języka (Kalisz, 1994: 70).

Podstawowa zasada kognitywnego ujęcia zjawiska metafory głosi, że jedna rzecz jest pojmowana w terminach innej rzeczy; jedna domena doświadczeniowa jest wyrażana poprzez odniesienie do drugiej domeny doświadczeniowej. Taką definicję metafory podaje Barcelona:

Metaphor is the cognitive mechanism whereby one experiential domain is partially „mapped“, i.e. projected, onto a different experiential domain, so that the second domain is partially understood in terms of the first one. The domain that is mapped is called the source or donor domain, and the domain onto which the source is mapped is called the target or recipient domain. Both domains have to belong to different superordinate domains (Barcelona, 2003: 3).

Innymi słowy, głównym aspektem teorii metafory kognitywnej jest zjawisko percepcji jednej dziedziny poprzez drugą. Jedna dziedzina, która dostarcza materiału leksykalnego, zwana dziedziną źródłową, należy do dziedzin fizycznych. Druga dziedzina dotyczy zjawisk psychologicznych, względnie abstrakcji, zwana jest dziedziną docelową (Kalisz, 1994: 70). Istnienie tych dwóch domen jest podstawą kognitywnego podejścia do metafory, zgodną z ustaleniami G. Lakoffa i M. Turnera. Zestawienie poglądów tych dwóch kognitywistów można znaleźć u Langackera: zdaniem pierwszego, „metaforyczne odwzorowania nie naruszają wyobrażeniowo-schematycznych struktur domeny źródłowej“ (Langacker, 2003: 87): Turner hipotezuje:

[…] w wypadku tych składników domeny źródłowej i docelowej, które uczestniczą w odwzorowaniu, struktura wyobrażeniowo-schematyczna domeny docelowej pozostaje nienaruszona, a ponadto na tyle, na ile to możliwe, struktura wyobrażeniowo-schematyczna domeny źródłowej zostaje przeniesiona do domeny docelowej, nie naruszając przy tym struktury tej ostatniej (Langacker, 2003: 87‑88).

Uwzględniając fakt, że obie w/w hipotezy kładą nacisk na reprezentację schematyczną, Langacker proponuje uzupełnienie struktury metaforycznej o pojęcie schematu. Zdaniem Langackera, schematyczna wspólna treść domeny źródłowej i docelowej również może być bardzo zróżnicowana, reprezentując szeroką gamę możliwości od analogii absolutnie oczywistej, poprzez nieco naciąganą i trudną do wyabstrahowania, a kończąc na wypadku granicznym, w którym elementy wspólne są właściwie bez znaczenia (Langacker, 2003: 88).

W terminologii literaturoznawczej domenę źródłową często nazywa się nośnikiem, a domenę docelową – tematem. Metafora przypisuje tematowi cechy wzięte z dziedziny nośnika poprzez ich abstrahowanie i przekazywanie do wspólnego pojęcia ogólnego. W pewnych przypadkach brak jest wspólnego pojęcia (węzła) łączącego temat i nośnik, które nadawałoby sens metaforze. W tym przypadku zostaje utworzony nowy węzeł. Nowo utworzone pojęcie ogólne jest generalizacją cech i schematów pochodzących z węzłów tematu i nośnika. Umysł, wykorzystując różne pojęcia ogólne oraz ich konkretne powiązania, łączy dziedzinę tematu i dziedzinę nośnika, często od siebie semantycznie odległe, dzięki czemu jedne aspekty tematu zostają uwypuklone, a inne są maskowane. Przesunięcie znaczenia, a właściwie wzbogacenie go, następuje poprzez odnalezienie nowych powiązań między cechami a nicią relacji temat-nośnik, które następuje dzięki odkryciu ogólniejszego pojęcia, łączącego obie dziedziny (Chlewiński, 1999: 280‑281). W interpretacji metafory pośredniczy szereg operacji myślowych takich jak myślenie metaforyczne, myślenie per analogiam, dedukcja hipotetyczna, abstrahowanie. Myślenie metaforyczne i analogiczne pełni istotną funkcję wykraczania poza aktualne struktury znaczeniowe i pojęciowe. Wydaje się, że jest ono komplementarne względem różnych postaci rozumowania, poddanego stosunkowo ścisłym rygorom formalnym i ukierunkowanego na tworzenie nowych struktur pojęciowych (Chlewiński, 1999: 286). W/w operacje myślowe należy włączać do procesu glottodydaktycznego w zależności od takich czynników, jak rodzaj nauczania (np. ekstensywne, intensywne), etap nauczania (np. średnio zaawansowany) oraz przyjęta orientacja psychologiczna (np. psychologia poznawcza) i lingwistyczna (np. lingwistyka kognitywna) . Jeśli chodzi o abstrahowanie, to jest to dość trudna dla uczącego się operacja myślowa. O jej twórczym charakterze decyduje jej przebieg.

Stąd też w programowaniu zadań dydaktycznych powinno się zwrócić uwagę na umożliwienie uczącemu się wielokrotnego kategoryzowania wybranego obiektu ze względu na różne kryteria definicyjne oraz ułatwienie zmiany perspektywy percepcji obiektu z abstrakcyjnej na konkretną. Wiąże się to ze zjawiskiem profilowania i nakładania profilu na bazę (Gorczyca, 2007: 159‑160).

Metafora jest zjawiskiem bardzo zróżnicowanym, dlatego też powstają rozmaite taksonomie, odzwierciedlające różne podejścia lingwistów i literaturoznawców. Lakoff i Johnson w swoich rozważaniach na temat metafor z życia codziennego, wyodrębniają metafory strukturalne, metafory orientacyjne oraz metafory ontologiczne. Kognitywiści ci uważają, że metafory są obecne nie tylko w języku, lecz również w myślach i czynach:

“We have found, on the contrary, that metaphor is pervasive in everyday life, not just in language but in thought and action. Our ordinary conceptual system, in terms of which we both think and act, is fundamentally metaphorical in nature” (Lakoff Johnson, 1980: 3). Lakoff i Johnson zwracają uwagę na systematyczność pojęć metaforycznych, która odzwierciedla się w systematyczności wyrażeń metaforycznych:

Because metaphorical concept is systematic, the language we use to talk about that aspect of the concept is systematic. […] Since metaphorical expressions in our language are tied to metaphorical concepts in a systematic way , we can use metaphorical linguistic expressions to study the nature of metaphorical concepts and to gain n understanding of the metaphorical nature of our activities (Lakoff Johnson, 1980: 7).

Wspominaliśmy wcześniej o metaforach strukturalnych, w których jedno pojęcie jest metaforycznie skonstruowane za pośrednictwem drugiego. Jeśli chodzi o metafory orientacyjne, to Lakoff i Johnson tak je definiują:

[…] there is another kind of metaphorical concept. One that does not structure one concept in terms of another but instead organizes a whole system of concepts with respect to one another. We will call these orientational metaphor, since most of them have to do with spatial orientation: up-down, in-out, front-back, on-off, deep-shallow, central-peripheral (Lakoff Johnson, 1980: 14).

Trzeci rodzaj metafor – metafory ontologiczne – ma podłoże doświadczeniowe. Metafory ontologiczne są wynikiem naszego doświadczania obiektów fizycznych, przede wszystkim naszego ciała; są sposobem postrzegania zdarzeń, czynności, emocji, idei jako istot i substancji. Metafory ontologiczne mogą służyć różnym celom, co przejawia się w ich różnorodności, jednakże, tak jak w przypadku metafor orientacyjnych, te cele są bardzo ograniczone. Podkreślmy, że to, co jest charakterystyczne w teorii Lakoffa i Johnsona to uznanie metafory za zjawisko codzienne, obecne nie tylko w języku, lecz również w myślach i czynach.

Do koncepcji Lakoffa i Johnsona odnosi się również Z. Chlewiński. Zdaniem Lakoffa i Johnsona, jak stwierdza, właśnie język jest istotnym źródłem wiedzy o tym, jaki jest nasz system pojęć, a badanie procesów metaforyzacji pozwala ukazać podstawowe mechanizmy generowania i rozwoju pojęć. Autorzy są przekonani, że w języku znaleźli szczególnie efektywny sposób badania, jak metafory kształtują myślenie, a nawet działanie. Chlewiński wyróżnia dwie klasy metafor: metafory martwe i metafory żywe.

Metafora martwa (genetyczna, potoczna) jest utartym zestawieniem słownym (temat-nośnik), wielokrotnie używanym przez posługujących się danym językiem. Metafora ta ma swoją utrwaloną konwencjonalność, choć posługuje się znaczeniami odmiennymi, i dlatego rozumiana jest automatycznie i jednoznacznie. Metafora genetyczna nie stanowi zagadki dla odbiorcy. Mówiący ma do dyspozycji dane wyrażenie jako standardowy (kodowy) sposób ekspresji danej treści (Chlewiński, 1999: 270).

Metaforze martwej autor przeciwstawia metaforę żywą (poetycką), która polega na tym, że dane wyrażenie zostaje użyte w nowym dla siebie kontekście. W metaforze żywej nadawca ma jakieś podstawy do zastosowania danego wyrażenia w nowej dla niego sytuacji, odbiorca zaś musi te podstawy odgadnąć, domyślić się, o jaką analogię tu chodzi. Metafora żywa wymaga więc interpretacji, pewnej odkrywczości, stanowiąc dla odbiorcy rodzaj zagadki. Istotna wartość metafory poetyckiej leży więc w jej odkrywczości w sferze wyrażeniowej, znaczeniowej i pojęciowej. Zdaniem Chlewińskiego, ustalenia Lakoffa i Johnsona dotyczą głównie metafor martwych, choć jednocześnie autorzy ci utożsamiają te dwa typy metafor. Nie jest to stwierdzenie słuszne, ponieważ metafora poetycka może eksponować inne nacechowania znaczenia, jeśli chodzi o określone schematy wyobrażeniowe. Ustalone przez Lakoffa i Johnsona znaczenie relacji dół – góra i góra – dół nie dają się często przenieść na sensy poetyckie wierszy.

W odróżnieniu od metafory poetyckiej metafory martwe nie stwarzają możliwości m.in. konkretyzacji, a co za tym idzie, interpretacji tekstu literackiego. Chlewiński pisze: „Innowacją Lakoffa i Johnsona jest to, że wyodrębnili oni i opisali różne typy metafor, które mogą tworzyć złożone systemy metaforyczne odwzorowujące sposób, w jaki pojmujemy całe klasy zjawisk, a to z kolei znajduje swoje odbicie w języku“ (Chlewiński, 1999: 270‑271).

Taylor i Langacker wspominają również o rozszerzeniach metaforycznych. Zdaniem Taylora, „źródłem rozszerzeń metaforycznych są metafory pojęciowe, które rzutują schemat góra-dół na inne obszary doświadczenia“ (Taylor, 2001: 191). A oto, co pisze na temat rozszerzeń metaforycznych Langacker (Langacker, 2003: 85‑86):

[…] równoległe relacje kategoryzujące mogą podlegać procesowi abstrahowania, który prowadzi o ukształtowania się reprezentacji schematycznych (dokładnie w taki sam sposób jak równoległe relacje kompozycjonalne dające podstawę dla schematów konstrukcyjnych). Możemy więc postulować schematy opisujące elementy wspólne dla bardziej szczegółowych odwzorowań metaforycznych. O tyle, o ile metafory mogą wiązać się z konkretnymi wyrażeniami schematy charakteryzują ustalone wzorce metaforycznego rozszerzenia (patterns of metaphorical extension).

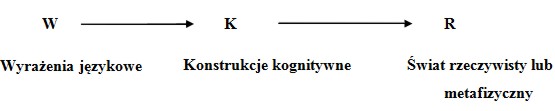

Najnowszym osiągnięciem językoznawstwa kognitywnego jest teoria amalgamatów pojęciowych (conceptual blending theory) autorstwa Gillesa Fauconniera i Marka Turnera. Teoria ta kładzie nacisk na integrację pojęć (amalgamowanie). Ja pisze A. Libura, u źródeł teorii integracji pojęć leży teoria przestrzeni mentalnych (mental spaces), które ulegają procesowi stapiania. Teoria przestrzeni mentalnych zakłada, że język jest jedynie powierzchniową manifestacją ukrytych, wysoce abstrakcyjnych konstrukcji kognitywnych (Libura, 2007: 13‑14). Związek pomiędzy wyrażeniami a rzeczywistością przedstawia się następująco:

Można znaleźć tutaj analogię do modelu sieciowego Langackera, aczkolwiek model Fauconniera nie uwzględnia procesów interakcyjnych.

To, co jednak interesuje nas najbardziej, to relacja pomiędzy teorią amalgamatów pojęciowych a kognitywnym ujęciem zjawiska metafory. Libura konfrontuje te dwie koncepcje, pisząc, że teorię amalgamatów można traktować po części jako uzupełnienie, a po części jako alternatywę wobec kognitywnej teorii metafory (Libura, 2007: 16). To, co łączy te dwie teorie, to kwestia rozumienia pojęć abstrakcyjnych poprzez odwoływanie się do pojęć konkretnych, bardziej rzeczywistych. Zarówno metafora, jak i amalgamat to aparaty kognitywne, dzięki którym zaawansowane struktury pojęciowe są przenoszone na wymiar rzeczywisty, bardziej dostępny ludzkiemu poznaniu. Teorie te różnią się jednak opisem operacji mentalnych. Koncepcje, które uprzednio przedstawiliśmy, wspominają o odwzorowaniu (mapping) lub projekcji (projection) struktury domeny źródłowej na docelową, natomiast w teorii Fauconniera i Turnera struktura pojęciowa przestrzeni mentalnych zostaje stopiona w nową całość, w efekcie czego powstaje zupełnie nowe znaczenie, które tworzy własną przestrzeń mentalną.

Przedstawione taksonomie podkreślają powszechność metafory w systemie pojęciowym, który z kolei znajduje swoje odzwierciedlenie w języku. Językoznawstwo kognitywne stawia metaforę w zupełnie nowym świetle i traktuje ją w sposób interdyscyplinarny.

Bibliografia:

- Barcelona, A. (2003). “Introduction. The cognitive theory of metaphor and metonymy”. W: Metaphor and metonymy at the crossroads: A cognitive perspective. Red. A. Barcelona. Berlin, s. 2‑10.

- Burzyńska, A. (2007a). „Wprowadzenie“. W: Teorie literatury XX wieku. Red. A. Burzyńska M.P. Markowski. Kraków, s. 13‑44.

- Burzyńska, A. (2007b). „Semiotyka“. W: Teorie literatury XX wieku. Red. A. Burzyńska M.P. Markowski, Kraków 2007, s. 231‑278.

- Chlewiński, Z. (1999). Umysł: dynamiczna organizacja pojęć: analiza psychologiczna. Warszawa.

- Fife, J. (1994a). „Wykłady z gramatyki kognitywnej. Wykład I“. W: Podstawy gramatyki kognitywnej. Red. H. Kardela. Warszawa, s. 9‑24.

- Fife, J. (1994b). „Wykłady z gramatyki kognitywnej. Wykład II“. W: Podstawy gramatyki kognitywnej. Red. H. Kardela. Warszawa, s. 24‑43.

- Gorczyca,W. (2000). Znaczenie i rozumienie w procesie recepcji i tworzenia tekstu obcojęzycznego. Warszawa.

- Gorczyca, W. (2007). Kognitywizm w glottodydaktyce. Wykłady. Bielsko-Biała.

- Jadacki, J. (1990). O rozumieniu. Z filozoficznych podstaw semiotyki, Warszawa.

- Kalisz, R. (1994). „Teoretyczne podstawy językoznawstwa kognitywnego“. W: Podstawy gramatyki kognitywnej. Red. H. Kardela. Warszawa, s. 65‑76.

- Korżyk, K. (1994). „Lingwistyka nie-autonomiczna?“ W: Podstawy gramatyki kognitywnej. Red. H. Kardela. Warszawa, s. 131‑147.

- Lakoff, G. Johnson, M. (1980). Metaphors we live by. Chicago, London.

- Langacker, R.W. (2003). „Model dynamiczny oparty na uzusie językowym“. W: Akwizycja w świetle językoznawstwa kognitywnego. Red. E. Dąbrowska i H. Kardela. Kraków, s. 28‑115.

- Libura, A. (2007). „Amalgamaty kognitywne. Powstanie i rozwój koncepcji integracji pojęciowej“ W: Amalgamaty pojęciowe w sztuce. Red. A. Libura. Kraków, s. 12‑66.

- Nowakowska-Kempna, I.(1995). Konceptualizacja uczuć w języku polskim. Prolegomena, Warszawa.

- Pawłowska, R. (1992). Lingwistyczna teoria nauki czytania. Gdańsk.

- Taylor, J.R. (2001). Kategoryzacja w języku. Prototypy w teorii językoznawczej. Przeł. A. Skucińska. Kraków.

Mohlo by vás z této kategorie také zajímat

- Mezijazykové interference ve slohových pracích studentů Českého centra Kyjev (Oleksandr Stukalo)

- Добри практики в обучението по превод (Гинка Бакърджиева)

- Za vidinou sladké odměny v podobě kostky cukru (Dana Ferenčáková)

- Vajanský, Šrobár, Gacek a reč dokumentu (Viera Žemberová)